详情内容

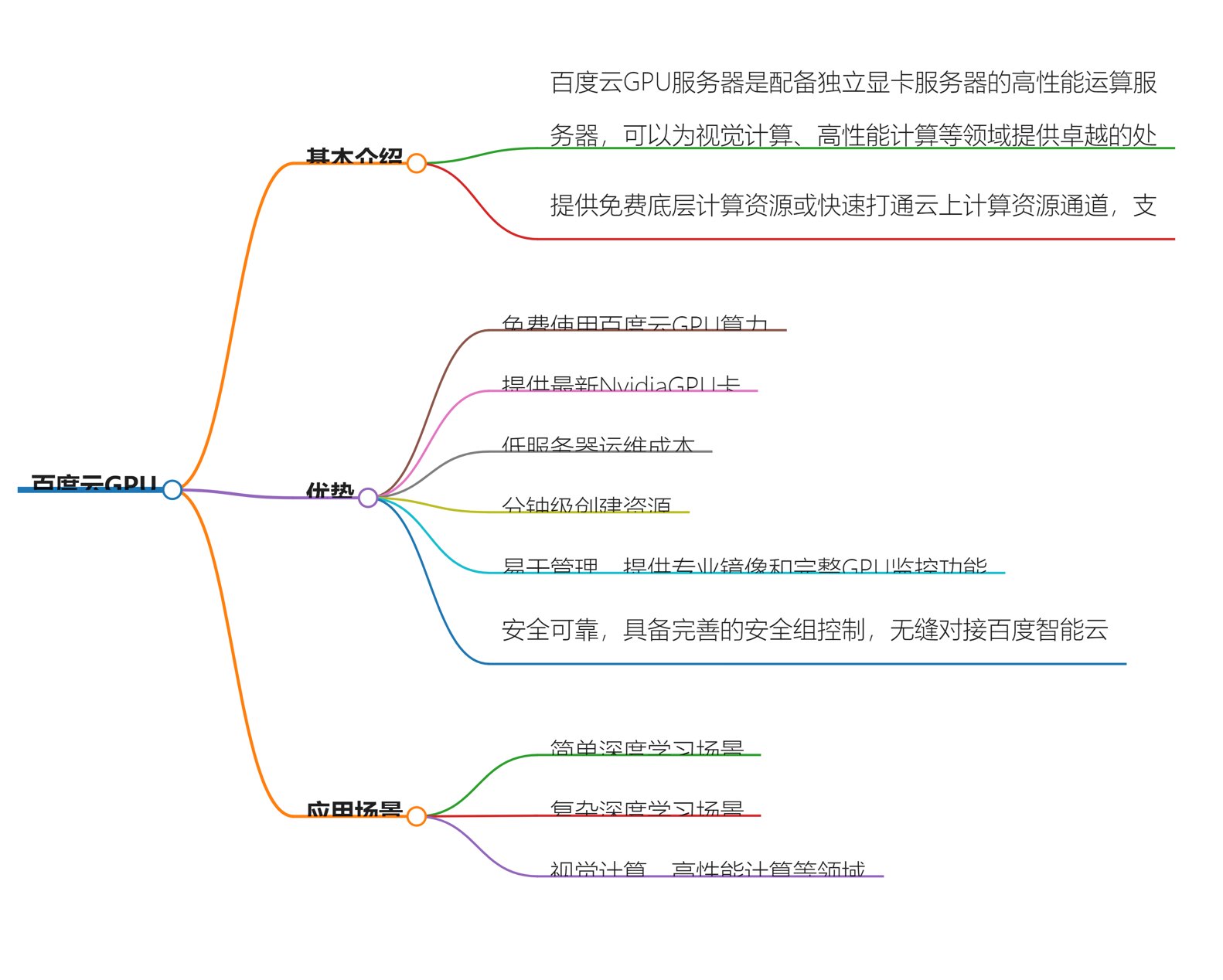

配备独享GPU的高性能云计算服务,可以为视觉计算、高性能计算等领域提供卓越的处理能力。根据需求场景的不同,既可提供更具灵活性和易用性的GPU云服务器,也可提供超高性能的GPU云服务器,助力您的业务创新,提升竞争优势。

一、产品功能

弹性按需易运维 丰富的使用模式 支持包年包月,按需,抢占等计费使用模式

多种GPU云服务器规格

提供NVIDIA Tesla A100、Tesla A10、Tesla V100、Tesla T4等多种高性能计算卡供用户自由选择,CPU、内存、磁盘配置随GPU数量线性增加。

分钟级创建资源

分钟级可轻松获取一个或多个GPU实例。

为全场景提供高性能加速能力

200G私有网络带宽

单个GPU云服务器可提供高达200G的私有网络带宽,提升与私有网络内与其他云上产品的数据通信。

RDMA高性能计算集群

自研网络架构,面向超大规模计算场景,提供GPU裸金属服务器之间RDMA网络互联能力,加速集群计算性能,降低GPU的闲置时间。

AI加速库

为AI计算场景提供加速引擎,优化模型中算子粒度的运行性能

二、应用场景

1.高性能计算

常见的高性能计算应用包括计算流体力学、分子动力学、有限元分析等,通常需要高精度算力来满足应用对精度的要求。消耗大量计算资源的同时会产生大量临时数据,对存储带宽与时延有非常高的要求。

我们能提供

提供最新的NVIDIA Tesla NVLink A100 GPU等型号的GPU,最高312TFLOPS的FP16深度学习计算性能,为AI和高性能计算打造功能强大的可扩展GPU加速服务平台。

可选择NVIDIA Tesla A100、NVIDIA Tesla V100等支持双精度浮点计算的GPU型号。

2.深度学习

针对深度学习的训练负载,有大批量的数据需要不断更新、迭代神经网络中的参数以满足业务对预测精度的要求;针对深度学习的在线推理场景,相比训练负载,推理负载对GPU性能的要求降低,但对运行稳定性要求更高,对服务器响应延时也有了更高要求。

我们能提供

提供支持Tensor Core功能的GPU做计算加速高性能的GPU型号来缩短网络模型的收敛时间。

可选择分布式训练提高计算效率并选择支持高速GPU互联能力的型号,例如Nvidia Tesla A100、Nvidia Tesla V100等。

NVIDIA Tesla T4 在满足性能要求的同时,提供更具性价比选择,同时支持GPU硬件级解码功能并加速端到端的图片类推理性能。

3.图像/视频渲染

专业级CAD、视频渲染、图形处理存在计算量大,处理时间长等问题,GPU卡可以提供强大计算能力。

我们为您解决

单精度FP32,性能高并支持光线追踪的GPU型号,例如Tesla A10、Tesla T4等。

基于Turing架构的NVIDIA Tesla T4 GPU加速器,具有极佳的图形计算能力。

终端或者客户端通过专用网络连接到主机来进行日常的工作,主机服务器常集中部署在数据中心机房,可通过GPU卡处理图形工作负载。

三、产品优势

1.节约成本

支持包年包月和按需等多种购买方式,提供最新Nvidia GPU卡的同时具备低服务器运维成本。

2.性能优异

支持分钟级创建资源,保持GPU性能无损,CPU、内存、本地磁盘配置与GPU数量按照最优比例组合。

3.简单易用

轻松对接百度智能云产品 ,提供专业镜像和完整GPU监控功能。

4.安全可靠

租户间通过私有网络VPC隔离,具备完善的安全组控制,无缝对接百度智能云安全服务。